IT 業界では常に話題の中心にいる LLM。2025年の現在、僕も職場では LLM ツール1にどっぷり浸かる毎日を過ごしています。しかし、高性能なモデルや API 経由での利用をしたい場合は追加課金が発生することが多いです。

ローカルマシンで LLM をホストできれば課金の必要はありません。また、導入プロセスを通じて LLM への理解をより深めたいと考えました。

そこでこの記事では、ローカルマシンへの LLM の導入から VSCode 上でコード編集機能を利用するまでにやったことを記録として残します。

動作を確認した環境は以下の通りです。

- PC

- Macbook Air M2 (2022年)

- RAM 16GB

- OS

- macOS Sequoia v15.3 (24D60)

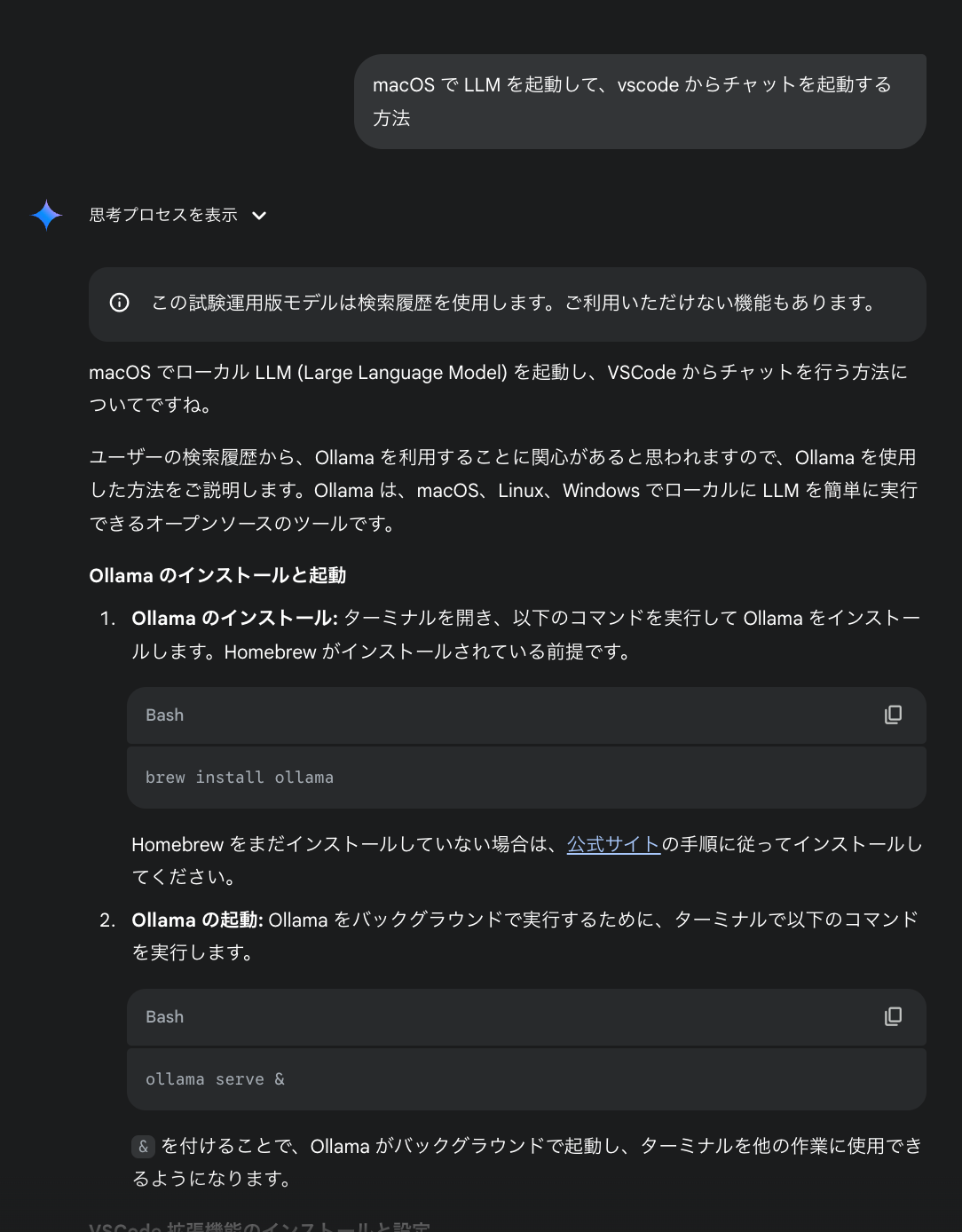

調査

Gemini に頼りました。

会話リンク: https://g.co/gemini/share/779a99352554

指示された手順はざっくり以下の通りです。

- Ollama をインストールして LLM を起動

- HTTP で LLM とやり取りできるサーバがバンドルされているらしい

- VSCode に Continue の拡張をインストールして ①の LLM を指定する

- LLM を使ってコードを書ける!

導入の流れ

1. Ollama 導入

似たソフトウェアとして LM Studio や、複数の LLM を一つのホストに集約することに主眼を置いたルーター系(勝手に命名しました)のプロジェクト2がありますが、Ollama はそれらと比較したときに以下のようなアドバンテージがあると理解しました。

- 高いポータビリティ

- コマンドラインのみで導入可能

- システムプロンプト等のカスタマイズ内容も Modelfile という Dockerfile ライクな形式のファイルで表現可能3

- VSCode への導入サポートの手厚さ

- 前述の Continue を使って楽チン

今回は Gemini の指示通り Ollama で進めます。

# ollama を Homebrew でインストール

$ brew install ollama

# ollama のサーバを起動

# この後は起動したまま別のターミナルから操作するか、コマンド末尾に `&` をつけてバックグラウンドジョブとして動かすかはお好みで

$ ollama serveollama では様々なモデルを利用できます。(モデル一覧) 最初は軽量かつ突飛な動作をしないであろうモデルを試したいと考え、Google が開発した Gemma 3 の 1B パラメータモデル4を選択しました。

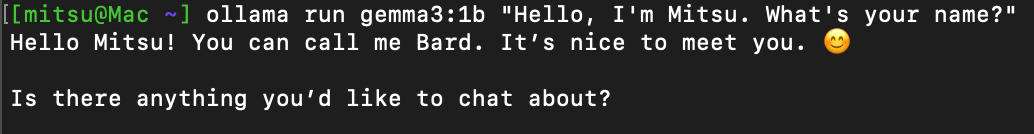

$ ollama pull gemma3:1bコマンドライン経由でのチャットも行えるようです。

シャ、シャベッタ!

ローカル LLM 導入のファーストステップはクリアです ✅

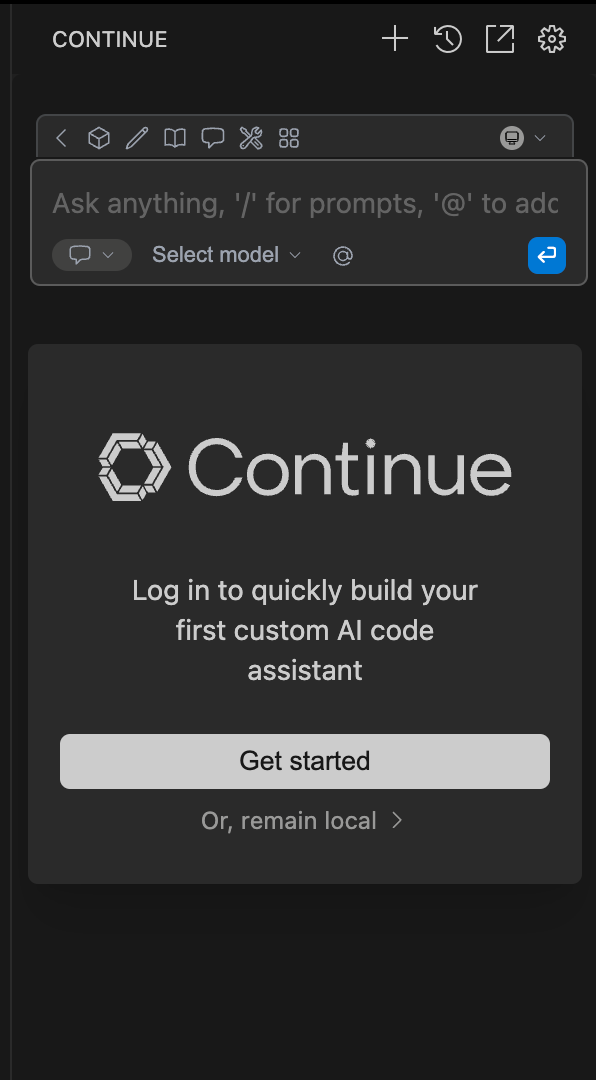

2. VSCode に Continue をインストール & 設定

| 説明 | スクリーンショット |

|---|---|

| インストール後初期画面 |  |

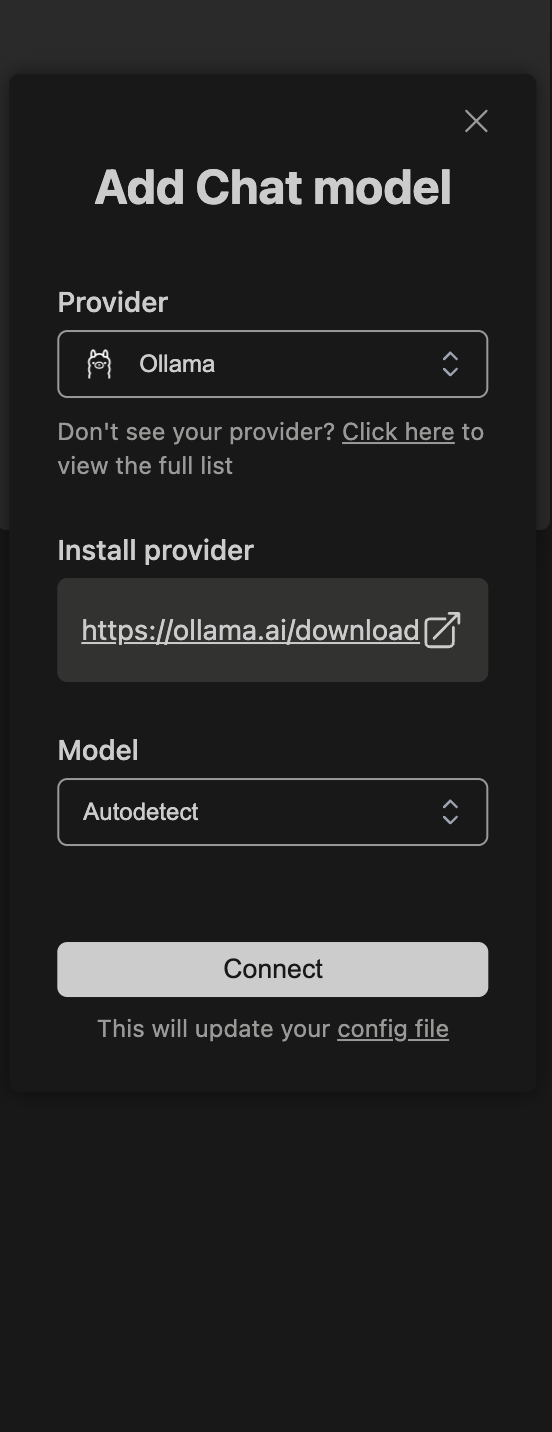

| Get started を開くとこの画面が開くので Ollama を選択する |  |

3. Ollama(Gemma 3)にコードを編集させる

手順2の設定を終えたら、モデル一覧から Gemma 3 が選択できるようになっています。

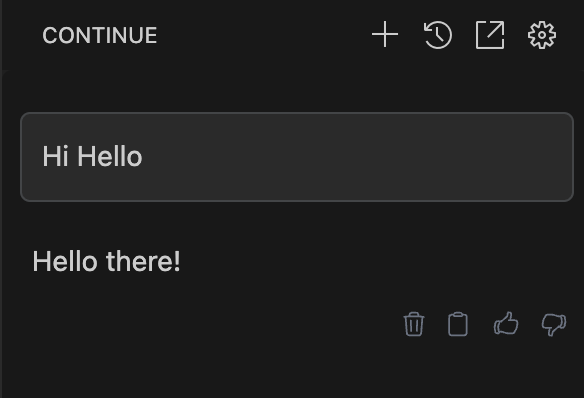

チャットは問題なさそうです。

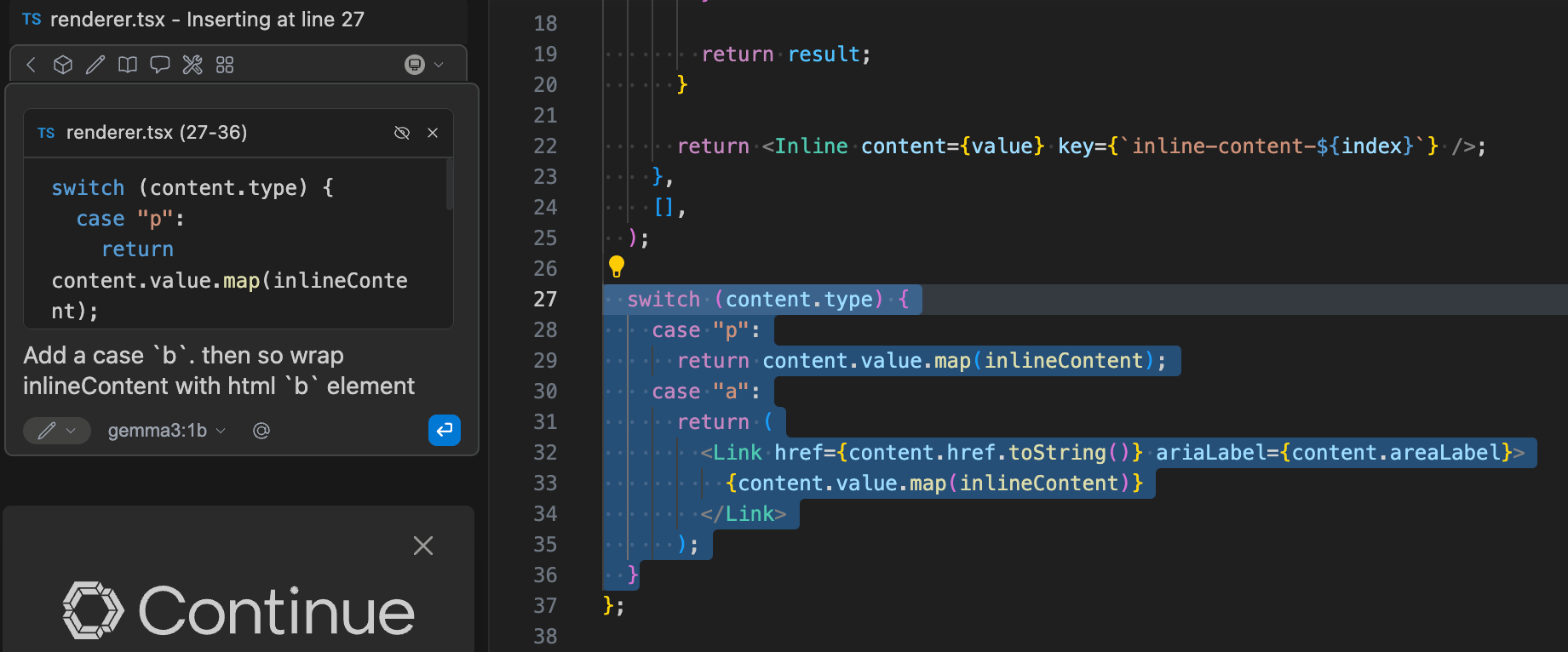

コードを選択して Add Highlighted Code to Context でチャット画面に指示のコンテクストとして追加できます。Copilot / Cursor と同じインターフェースですね。

うーん、これじゃない…業務で使う Claude 3.7 Sonnet 辺りのモデルよりも明らかな知識/文脈理解の不足を感じます。より賢くてコーディングに特化したモデルを使う必要がありそうです。

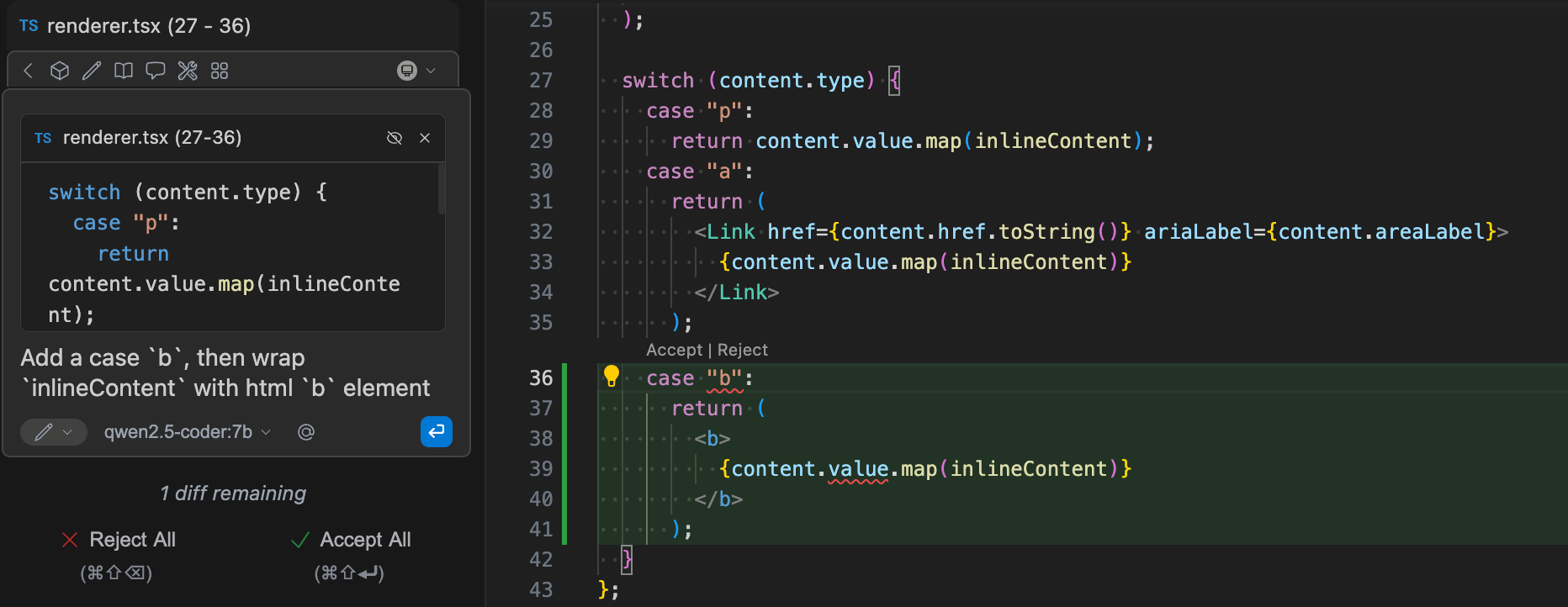

ということでコーディング特化モデルの中で pull 数が多くサイズも大きすぎない qwen2.5-coder:7b を試しました

こちらは期待通りの出力が得られました 🙌

まとめ

シンプルな手順で LLM 導入 + VSCode 連携まで構築できました。

また、シンプルなタスクであれば精度高く実行できるモデルがローカルでホストできることも確認できました。

個人用途ならローカルで十分かもしれません。夢が広がりますね

Footnotes

-

記事執筆時点では、調べ物は ChatGPT(プライベートでは Gemini と Grok を使い分け)、一つの文書を元にしたい場合は NotebookLM、コーディング時は GitHub Copilot と Devin をよく利用しています ↩

-

サクッと調べると LLM Router, RouteLLM 辺りの情報が多いように感じました ↩

-

https://ollama.com/library/gemma3 ; 1b=10億パラメータの機械学習モデルをラップトップでサクッと動かせることにビビりました ↩